Introducción: el caso ITLA y la conversación digital

Las redes sociales se han consolidado como uno de los principales espacios de debate público y formación de opinión. Sin embargo, en determinadas coyunturas ese debate parece alterarse de manera abrupta, tanto en volumen como en tono. Un ejemplo reciente en la República Dominicana es el generado tras la publicación de una investigación periodística sobre el director del Instituto Tecnológico de las Américas (ITLA), investigación que derivó posteriormente en su destitución por decisión presidencial.

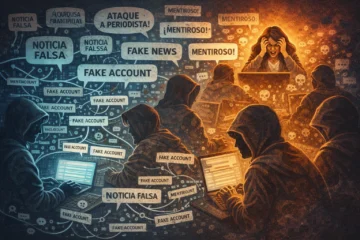

Tras las publicaciones de la periodista autora del reportaje —y de otros profesionales que abordaron el mismo tema— se produjo un fenómeno llamativo en redes sociales: un volumen inusualmente alto de comentarios, muchos de ellos con mensajes muy similares entre sí, acusaciones de “noticias falsas” y ataques personales dirigidos a periodistas. La magnitud y la homogeneidad de estas reacciones marcaron una clara ruptura con los patrones habituales de participación digital.

¿Qué es un chatbot y cómo interviene en redes sociales?

Este tipo de episodios no es exclusivo de la República Dominicana. En distintos países se han observado comportamientos similares en momentos de alta sensibilidad política o mediática. Cada vez con mayor frecuencia, estos fenómenos se analizan a la luz del uso de chatbots y redes automatizadas, diseñadas para influir en la conversación pública.

Un chatbot es un programa informático capaz de generar respuestas automáticas que simulan la interacción humana. En sus versiones más simples funciona a partir de reglas predefinidas; en las más avanzadas utiliza modelos de inteligencia artificial entrenados con grandes volúmenes de datos lingüísticos. En el contexto de las redes sociales, estos sistemas pueden publicar comentarios, responder a otros usuarios y replicar mensajes de manera masiva y casi instantánea.

Cuando múltiples chatbots actúan de forma coordinada, se configura lo que se conoce como una red automatizada. Estas redes pueden crear la ilusión de una reacción social espontánea, amplia y homogénea, cuando en realidad se trata de una actividad artificial orientada a amplificar determinadas narrativas o desacreditar otras.

La relación entre bots y trolls

En el análisis de campañas de desinformación y ataques coordinados en redes sociales, es importante distinguir entre bots (incluyendo chatbots) y trolls, conceptos que a menudo se confunden pero que cumplen funciones distintas y complementarias.

Los bots son programas automatizados diseñados para operar a gran escala. Su función principal es amplificar mensajes, repetir narrativas, generar volumen artificial de interacciones y dar la impresión de consenso o rechazo masivo. Actúan con rapidez y persistencia, pero carecen de comprensión contextual y creatividad propia.

Los trolls, en cambio, son personas reales que intervienen deliberadamente en el debate con el objetivo de provocar, intimidar o desviar la conversación. A diferencia de los bots, los trolls comprenden el contexto, adaptan su lenguaje y apelan a emociones como la ira, el miedo o el descrédito personal.

En muchas campañas coordinadas, ambos actores trabajan de forma conjunta: los chatbots preparan el terreno generando visibilidad y aparente apoyo, mientras que los trolls intensifican el conflicto mediante ataques personalizados. A su vez, los chatbots amplifican las intervenciones de los trolls, reforzando su alcance y legitimidad aparente.

Uso y efectividad real

Los chatbots no son herramientas negativas en sí mismos. Se utilizan de forma legítima en atención al cliente, educación, servicios públicos y marketing digital. El problema surge cuando se emplean de manera opaca en el espacio político o mediático, para desacreditar investigaciones periodísticas, polarizar artificialmente el debate o intimidar voces críticas.

La evidencia sugiere que los chatbots rara vez cambian opiniones profundamente arraigadas. Su impacto suele ser indirecto: distorsionan la conversación pública, generan ruido informativo y crean sensación de conflicto permanente. Al saturar los espacios digitales con mensajes repetitivos, pueden desalentar la participación de periodistas y ciudadanos.

Panorama internacional: distintos modelos de respuesta

En Estados Unidos, el debate se centra en la responsabilidad de las plataformas tecnológicas. En la Unión Europea, el enfoque es más normativo, exigiendo transparencia sobre contenidos automatizados. En Rusia y China, la automatización forma parte de estrategias estatales de influencia o control.

En América Latina, la combinación de marcos regulatorios débiles, recursos limitados y alta polarización genera vulnerabilidad a la manipulación digital. En la República Dominicana, el debate aún es incipiente y la detección depende de las plataformas.

Recomendaciones y conclusiones

La respuesta no debe ser la censura, sino la transparencia. Se requiere alfabetización digital en medios y educación, protección a periodistas frente a ataques coordinados, y marcos regulatorios que exijan revelar el uso de automatización en contextos políticos. Los chatbots no son el problema: el desafío real es cómo se utilizan y cómo se protege la calidad del debate democrático.

Compartir esta nota